Autoridade Robert Triggs / Android

Outro dia, outro grande modelo de idioma, mas as notícias de que o OpenAI lançou seus primeiros modelos de peso aberto (GPT-ROSS) com o licenciamento Apache 2.0 é um negócio maior do que a maioria. Por fim, você pode executar uma versão do ChatGPT offline e de graça, dando aos desenvolvedores e dos entusiastas da IA casual outra ferramenta poderosa para experimentar.

Como sempre, o OpenAI faz algumas grandes reivindicações sobre as capacidades do GPT-OSS. Aparentemente, o modelo pode superar o O4-mini e as pontuações bem próximas ao seu modelo O3-modelos de raciocínio econômicos e mais poderosos da OpenAI, respectivamente. No entanto, esse modelo GPT-OSS vem em um colossal de 120 bilhões de parâmetros, exigindo que algum kit de computação sério seja executado. Para você e eu, porém, ainda existe um modelo de parâmetro de 20 bilhões de desempenho altamente performance.

Agora você pode executar o ChatGPT offline e de graça? Bem, depende.

Em teoria, o modelo de parâmetro de 20 bilhões será executado em um laptop ou PC moderno, desde que você tenha uma RAM abundante e uma poderosa CPU ou GPU para analisar os números. A Qualcomm até afirma que está empolgado em trazer o GPT OSS para suas plataformas de computação-pense em PC e não móvel. Ainda assim, isso implora a pergunta: é possível executar agora o ChatGPT totalmente offline e no dispositivo, de graça, em um laptop ou até no seu smartphone? Bem, é factível, mas eu não recomendaria.

O que você precisa para executar o GPT-Oss?

Edgar Cervantes / Autoridade Android

Apesar de encolher o GPT-OSS de 120 bilhões para 20 bilhões de parâmetros para uso mais geral, o modelo oficial quantizado ainda pesa em 12,2 GB. O OpenAI especifica os requisitos de VRAM de 16 GB para o modelo 20B e 80 GB para o modelo 120B. Você precisa de uma máquina capaz de manter a coisa toda na memória imediatamente para obter um desempenho razoável, o que o coloca firmemente no território NVIDIA RTX 4080 para a memória GPU dedicada suficiente – dificilmente algo ao qual todos temos acesso.

Para PCs com um VRAM GPU menor, você deseja 16 GB de RAM do sistema se puder dividir parte do modelo na memória da GPU e, de preferência, uma GPU capaz de analisar dados de precisão do FP4. Para todo o resto, como laptops e smartphones típicos, 16 GB está realmente cortando bem, pois você também precisa de espaço para o sistema operacional e aplicativos. Com base na minha experiência, é necessária RAM de 24 GB; Meu laptop de superfície da 7ª geração, completo com um processador Snapdragon X e 16 GB de RAM, trabalhou em 10 tokens decentes por segundo, mas mal mantidos mesmo com todos os outros aplicativos fechados.

Apesar de seu tamanho menor, o GPT-OSS 20B ainda precisa de bastante RAM e uma GPU poderosa para correr sem problemas.

Obviamente, sendo o ideal de 24 GB de RAM, a grande maioria dos smartphones não pode executá -lo. Até os líderes da IA como o Pixel 9 Pro XL e o Galaxy S25 Ultra de 16 GB de RAM, e nem tudo isso é acessível. Felizmente, meu Phone Rog 9 Pro tem um colossal 24 GB de RAM – o suficiente para me iniciar.

Como executar o GPT-Oss em um telefone

Autoridade Robert Triggs / Android

Para minha primeira tentativa de executar o GPTs no meu smartphone Android, voltei-me para a crescente seleção de aplicativos LLM que permitem executar modelos offline, incluindo PocketPal AI, bate-papo de lhama e playground LM.

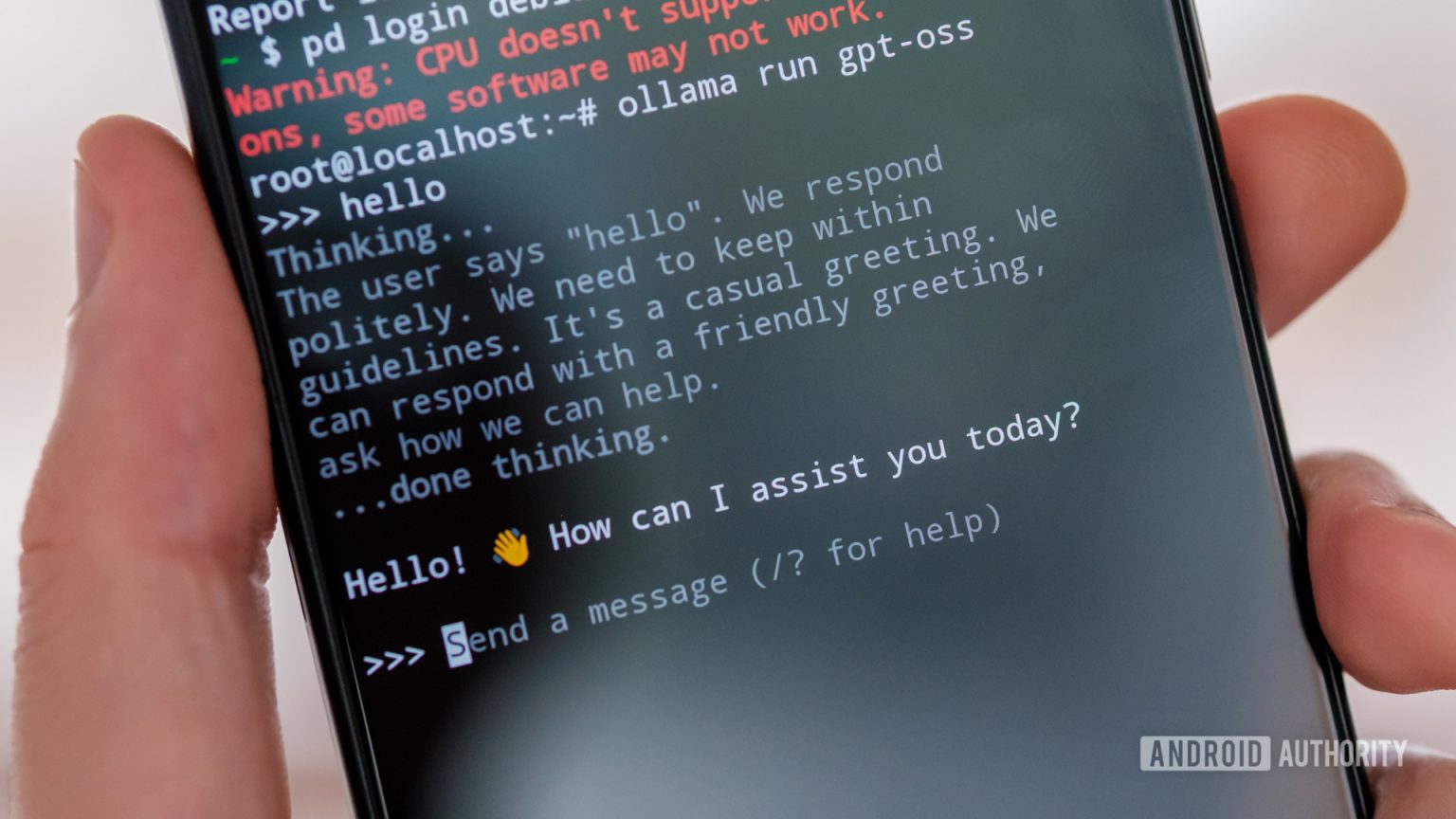

No entanto, esses aplicativos não tinham o modelo disponível ou não conseguiram carregar com sucesso a versão baixada manualmente, possivelmente porque são baseados em uma versão mais antiga do llama.cpp. Em vez disso, iniciei uma partição debian no ROG e instalei Ollama para lidar com o carregamento e interagindo com o GPT-ROSS. Se você quiser seguir as etapas, fiz o mesmo com a Deepseek no início do ano. A desvantagem é que o desempenho não é nativo e não há aceleração de hardware, o que significa que você depende da CPU do telefone para fazer o trabalho pesado.

Então, quão bem o GPTs é executado em um smartphone Android de primeira linha? Mal é a palavra generosa que eu usaria. A elite Snapdragon 8 do ROG pode ser poderosa, mas não está nem perto do Snapdragon X do meu laptop, muito menos uma GPU dedicada para a crise de dados.

O GPTs pode executar um telefone, mas é quase utilizável.

A taxa de token (a taxa na qual o texto é gerada na tela) é quase passável e certamente mais lenta do que eu posso ler. Eu estimaria que está na região de 2-3 tokens (cerca de uma palavra ou mais) por segundo. Não é totalmente terrível para pedidos curtos, mas é agonizante se você quiser fazer algo mais complexo do que dizer olá. Infelizmente, a taxa de token só piora à medida que o tamanho da sua conversa aumenta, eventualmente levando alguns minutos para produzir até alguns parágrafos.

Autoridade Robert Triggs / Android

Obviamente, as CPUs móveis realmente não foram criadas para esse tipo de trabalho, e certamente não são modelos que se aproximam desse tamanho. O ROG é um artista Nippy para minhas cargas de trabalho diárias, mas foi maximizado aqui, fazendo com que sete dos oito núcleos da CPU funcionassem a 100% quase constantemente, resultando em um aparelho bastante quente após apenas alguns minutos de bate -papo. As velocidades do relógio aceleraram rapidamente, fazendo com que as velocidades do token caíssem ainda mais. Não é ótimo.

Com o modelo carregado, os 24 GB do telefone também foram esticados, com o sistema operacional, aplicativos de fundo e memória adicional necessária para o prompt e as respostas que disputam o espaço. Quando eu precisava entrar e sair dos aplicativos, eu pude, mas isso levou a geração de token já lenta a uma parada virtual.

Outro modelo impressionante, mas não para telefones

Calvin Wankhede / Autoridade Android

A execução do GPT OSS em seu smartphone está praticamente fora de questão, mesmo se você tiver um enorme pool de RAM para carregá-lo. Modelos externos destinados principalmente à comunidade de desenvolvedores não suportam NPUs e GPUs móveis. A única maneira de contornar esse obstáculo é que os desenvolvedores aproveitem os SDKs proprietários, como o AI SDK da Qualcomm ou o ML principal da Apple, o que não acontecerá para esse tipo de caso de uso.

Ainda assim, eu estava determinado a não desistir e experimentar o GPTs no meu PC envelhecido, equipado com uma RAM GTX1070 e 24 GB. Os resultados foram definitivamente melhores, em torno de quatro a cinco tokens por segundo, mas ainda mais lento que o meu laptop Snapdragon X em execução apenas na CPU – caramba.

Nos dois casos, a versão de parâmetros 20B do GPT-OSS certamente parece impressionante (depois de esperar um tempo), graças à sua cadeia de raciocínio configurável que permite que o modelo “pense” por mais tempo para ajudar a resolver problemas mais complexos. Comparado às opções gratuitas como o Gemini 2.5 Flash do Google, o GPTSS é o solucionador de problemas mais capaz, graças ao uso da cadeia de pensamentos, como o Deepseek R1, o que é ainda mais impressionante, devido ao grátis. No entanto, ainda não é tão poderoso quanto os modelos mais poderosos e mais caros baseados em nuvem-e certamente não é tão rápido quanto a nenhum gadgets de consumo que eu possuo.

Ainda assim, o raciocínio avançado na palma da sua mão, sem o custo, as preocupações de segurança ou os compromissos de rede dos modelos de assinatura atual, é o futuro da IA que acho que laptops e smartphones devem realmente buscar. Há claramente um longo caminho a percorrer, especialmente quando se trata de aceleração de hardware convencional, mas à medida que os modelos se tornam mais inteligentes e menores, esse futuro parece cada vez mais tangível.

Alguns dos meus principais smartphones se mostraram razoavelmente hábeis em executar modelos menores de 8 bilhões de parâmetros como Qwen 2.5 e Llama 3, com resultados surpreendentemente rápidos e poderosos. Se algum dia virmos uma versão igualmente rápida do GPT-ROSS, eu ficaria muito mais animado.

Obrigado por fazer parte da nossa comunidade. Leia nossa política de comentários antes de postar.